Tutoriales y Manuales

Entradas Mensuales

-

▼

2025

(Total:

2103

)

- ► septiembre (Total: 148 )

-

▼

enero

(Total:

165

)

-

Inteligencia artificial, TOPs y tokens

Inteligencia artificial, TOPs y tokens

-

uBlock Origin dejará de funcionar en Chrome

uBlock Origin dejará de funcionar en Chrome

-

Francia tenía su propia IA para competir con ChatG...

Francia tenía su propia IA para competir con ChatG...

-

México pide en una carta a Google corregir lo que ...

México pide en una carta a Google corregir lo que ...

-

GPU AMD RX 7900 XTX supera a la NVIDIA RTX 4090 en...

GPU AMD RX 7900 XTX supera a la NVIDIA RTX 4090 en...

-

El FBI cierra los dominios de los foros de pirater...

El FBI cierra los dominios de los foros de pirater...

-

DeepSeek sufre una filtración de datos

DeepSeek sufre una filtración de datos

-

Actualizaciones de seguridad críticas para iPhone,...

Actualizaciones de seguridad críticas para iPhone,...

-

Parece un inocente PDF, pero es una estafa bancari...

Parece un inocente PDF, pero es una estafa bancari...

-

DeepSeek tendrá un clon «100% abierto» desarrollad...

DeepSeek tendrá un clon «100% abierto» desarrollad...

-

¿Qué son los tokens en el contexto de los LLM?

¿Qué son los tokens en el contexto de los LLM?

-

¿Qué es el destilado de una LLM?

¿Qué es el destilado de una LLM?

-

Se saltan el sistema de cifrado BitLocker de Windo...

Se saltan el sistema de cifrado BitLocker de Windo...

-

Facebook bloquea cualquier tema de Linux de Distro...

Facebook bloquea cualquier tema de Linux de Distro...

-

Ramsomware Makop y Lynx

Ramsomware Makop y Lynx

-

NVIDIA pide explicaciones a Super Micro por vender...

NVIDIA pide explicaciones a Super Micro por vender...

-

Investigadores canadienses afirman que un ajuste d...

Investigadores canadienses afirman que un ajuste d...

-

Vulnerabilidad crítica en Cacti (SNMP)

Vulnerabilidad crítica en Cacti (SNMP)

-

FARM discos duros Seagate

FARM discos duros Seagate

-

DeepSeek habría sido entrenada con datos robados a...

DeepSeek habría sido entrenada con datos robados a...

-

Alibaba presenta Qwen2.5-Max, su poderosa IA

Alibaba presenta Qwen2.5-Max, su poderosa IA

-

Huawei dice tener un chip para IA igual de potente...

Huawei dice tener un chip para IA igual de potente...

-

El fabricante de móviles Oppo es víctima de una gr...

El fabricante de móviles Oppo es víctima de una gr...

-

DeepSeek puede crear malware para robar tarjetas d...

DeepSeek puede crear malware para robar tarjetas d...

-

Historia del fabricante Asus

Historia del fabricante Asus

-

Instalar DeepSeek (destilado) con Ollama en tu ord...

Instalar DeepSeek (destilado) con Ollama en tu ord...

-

Lossless Scaling: ¿Qué es y cómo funciona?

Lossless Scaling: ¿Qué es y cómo funciona?

-

Una hora de anuncios para ver un simple vídeo de Y...

Una hora de anuncios para ver un simple vídeo de Y...

-

Herramientas gratuitas para transcribir de audio a...

Herramientas gratuitas para transcribir de audio a...

-

OpenAI Operator: el agente de IA que automatiza ta...

OpenAI Operator: el agente de IA que automatiza ta...

-

DeepSeek Janus-Pro-7B, otro modelo de IA multimoda...

DeepSeek Janus-Pro-7B, otro modelo de IA multimoda...

-

DeepSeek es víctima de un ataque DDoS

DeepSeek es víctima de un ataque DDoS

-

NVIDIA DLSS 4 (Tecnología de Escalado de nvidia)

NVIDIA DLSS 4 (Tecnología de Escalado de nvidia)

-

Sony abandona los discos Blu-Ray grabables, MiniDi...

Sony abandona los discos Blu-Ray grabables, MiniDi...

-

Vulnerabilidad en el framework Llama Stack de Meta...

Vulnerabilidad en el framework Llama Stack de Meta...

-

PayPal pagará 2 millones de dólares por la filtrac...

PayPal pagará 2 millones de dólares por la filtrac...

-

DeepSeek, la herramienta china que revoluciona la ...

DeepSeek, la herramienta china que revoluciona la ...

-

119 vulnerabilidades de seguridad en implementacio...

119 vulnerabilidades de seguridad en implementacio...

-

Cómo bloquear y demorar bots IA de Scraping web

Cómo bloquear y demorar bots IA de Scraping web

-

Oracle, en negociaciones con ByteDance para compra...

Oracle, en negociaciones con ByteDance para compra...

-

Descubren que Elon Musk hacía trampas en los juego...

Descubren que Elon Musk hacía trampas en los juego...

-

Por ser cliente de Movistar en España tienes grati...

Por ser cliente de Movistar en España tienes grati...

-

HDMI 2.2 VS DisplayPort 2.1

HDMI 2.2 VS DisplayPort 2.1

-

Filtrados datos personales de asegurados de Asisa

Filtrados datos personales de asegurados de Asisa

-

Los fallos que cometió Ulbricht para ser detenido:...

Los fallos que cometió Ulbricht para ser detenido:...

-

Instagram desata las críticas de los usuarios espa...

Instagram desata las críticas de los usuarios espa...

-

Donald Trump indulta a Ross Ulbricht, creador del ...

Donald Trump indulta a Ross Ulbricht, creador del ...

-

Alia, la IA del Gobierno Español, es un desastre: ...

Alia, la IA del Gobierno Español, es un desastre: ...

-

Stargate, un proyecto de Estados Unidos para inver...

Stargate, un proyecto de Estados Unidos para inver...

-

Ataques del ransomware BlackBasta mediante Microso...

Ataques del ransomware BlackBasta mediante Microso...

-

El mayor ataque DDoS registrado alcanzó 5,6Tb/s me...

El mayor ataque DDoS registrado alcanzó 5,6Tb/s me...

-

Tras el éxito de Doom en documentos PDF, ahora tam...

Tras el éxito de Doom en documentos PDF, ahora tam...

-

Cae una banda de ciberestafadores que enviaba hast...

Cae una banda de ciberestafadores que enviaba hast...

-

Cómo desactivar el Antimalware Service Executable ...

Cómo desactivar el Antimalware Service Executable ...

-

Herramienta Restablecer Windows

Herramienta Restablecer Windows

-

Seagate llega a los 36 TB con sus nuevos discos du...

Seagate llega a los 36 TB con sus nuevos discos du...

-

YST (‘Yo soy tú’, como se autodenominó irónicament...

YST (‘Yo soy tú’, como se autodenominó irónicament...

-

¿Qué es la pipeline?

¿Qué es la pipeline?

-

Una chica de 28 años se enamora de ChatGPT

Una chica de 28 años se enamora de ChatGPT

-

Copilot+ ya permite la búsqueda local

Copilot+ ya permite la búsqueda local

-

DORA: la normativa europea que obliga a los bancos...

DORA: la normativa europea que obliga a los bancos...

-

Apple desactiva funciones de Apple Intelligence po...

Apple desactiva funciones de Apple Intelligence po...

-

La empresa de hosting GoDaddy, obligada a reforzar...

La empresa de hosting GoDaddy, obligada a reforzar...

-

Domina los ficheros PDF con dos servicios Docker

Domina los ficheros PDF con dos servicios Docker

-

OpenAI desarrolla una IA para prolongar la vida hu...

OpenAI desarrolla una IA para prolongar la vida hu...

-

TikTok cierra en Estados Unidos

TikTok cierra en Estados Unidos

-

Vulnerabilidad permite eludir UEFI Secure Boot

Vulnerabilidad permite eludir UEFI Secure Boot

-

Normativa Drones España 2025

Normativa Drones España 2025

-

Robados los datos personales de 97.000 aspirantes ...

Robados los datos personales de 97.000 aspirantes ...

-

¿Cómo volar un dron de noche? Esta es la normativa...

¿Cómo volar un dron de noche? Esta es la normativa...

-

Expuestas 15.000 configuraciones robadas de FortiG...

Expuestas 15.000 configuraciones robadas de FortiG...

-

Filtración masiva en China expone 1.500 millones d...

Filtración masiva en China expone 1.500 millones d...

-

Un ciberataque expone la identidad de 160.000 guar...

Un ciberataque expone la identidad de 160.000 guar...

-

La Policía de España advierte sobre una nueva técn...

La Policía de España advierte sobre una nueva técn...

-

Microsoft estrena protección del administrador de ...

Microsoft estrena protección del administrador de ...

-

Windows 11 con sólo 184 MB de RAM

Windows 11 con sólo 184 MB de RAM

-

Evilginx 3 para ataques man-in-the-middle mediante...

Evilginx 3 para ataques man-in-the-middle mediante...

-

Cómo Barcelona se convirtió en un centro de empres...

Cómo Barcelona se convirtió en un centro de empres...

-

El Gobierno de España anuncia la creación de un Ce...

El Gobierno de España anuncia la creación de un Ce...

-

RDP Bitmap Forensics para investigaciones DFIR

RDP Bitmap Forensics para investigaciones DFIR

-

Más de 660.000 servidores Rsync expuestos a ataque...

Más de 660.000 servidores Rsync expuestos a ataque...

-

El FBI elimina el malware chino PlugX en 4.250 ord...

El FBI elimina el malware chino PlugX en 4.250 ord...

-

Hiren's BootCD PE con Windows 11

Hiren's BootCD PE con Windows 11

-

Las chicas del ENIAC y las programadoras de los Co...

Las chicas del ENIAC y las programadoras de los Co...

-

Trucos de Windows 11

Trucos de Windows 11

-

Millones de cuentas vulnerables por fallo en OAuth...

Millones de cuentas vulnerables por fallo en OAuth...

-

Si no actualizas a Windows 11, no podrás usar Offi...

Si no actualizas a Windows 11, no podrás usar Offi...

-

Jugar al DOOM dentro de un archivo PDF

Jugar al DOOM dentro de un archivo PDF

-

Los mejores procesadores para jugar en 2025, ¿cuán...

Los mejores procesadores para jugar en 2025, ¿cuán...

-

"Explotación masiva" de los firewalls de Fortinet ...

"Explotación masiva" de los firewalls de Fortinet ...

-

Cómo funciona la sincronización en el almacenamien...

Cómo funciona la sincronización en el almacenamien...

-

Parallels ya permite emular Windows y Linux las Ma...

Parallels ya permite emular Windows y Linux las Ma...

-

Ransomware en Servidores ESXi: Amenazas, Vulnerabi...

Ransomware en Servidores ESXi: Amenazas, Vulnerabi...

-

Roban información con Infostealer Lumma mediante t...

Roban información con Infostealer Lumma mediante t...

-

Cómo compartir contraseñas en Google Chrome con "M...

Cómo compartir contraseñas en Google Chrome con "M...

-

El arquitecto jefe de Xeon cambia de Intel a Qualc...

El arquitecto jefe de Xeon cambia de Intel a Qualc...

-

Hackean cuentas de Path of Exile 2 tras robar una ...

Hackean cuentas de Path of Exile 2 tras robar una ...

-

Microsoft consigue que su IA se vuelva experta en ...

Microsoft consigue que su IA se vuelva experta en ...

-

Cómo instalar Stremio en Raspberry Pi para conecta...

Cómo instalar Stremio en Raspberry Pi para conecta...

-

"Free our Feeds" quiere evitar que los millonarios...

"Free our Feeds" quiere evitar que los millonarios...

-

-

►

2024

(Total:

1110

)

- ► septiembre (Total: 50 )

-

►

2023

(Total:

710

)

- ► septiembre (Total: 65 )

-

►

2022

(Total:

967

)

- ► septiembre (Total: 72 )

-

►

2021

(Total:

730

)

- ► septiembre (Total: 56 )

-

►

2020

(Total:

212

)

- ► septiembre (Total: 21 )

-

►

2019

(Total:

102

)

- ► septiembre (Total: 14 )

-

►

2017

(Total:

231

)

- ► septiembre (Total: 16 )

-

►

2016

(Total:

266

)

- ► septiembre (Total: 38 )

-

►

2015

(Total:

445

)

- ► septiembre (Total: 47 )

-

►

2014

(Total:

185

)

- ► septiembre (Total: 18 )

-

►

2013

(Total:

100

)

- ► septiembre (Total: 3 )

-

►

2011

(Total:

7

)

- ► septiembre (Total: 1 )

Blogroll

Etiquetas

Entradas populares

Entradas populares

-

ClothOff es una app que utiliza inteligencia artificial generativa para desnudar a cualquier persona a partir de fotografías con ropa que...

-

Investigadores han descubierto a DarkSpectre, un grupo de amenazas chino bien financiado responsable de infectar a más de 8.8 millones de us...

-

Una solución de código abierto para gestionar copias de seguridad cifradas de WhatsApp. La suite wa-crypt-tools, alojada en GitHub, descifra...

Instalar DeepSeek (destilado) con Ollama en tu ordenador para usarlo de forma local

Instalar DeepSeek (destilado) con Ollama en tu ordenador para usarlo de forma local

Cómo instalar DeepSeek en tu ordenador, para poder utilizarlo cuando quieras. Hay varias maneras de hacerlo, pero nosotros vamos a intentar recurrir a una de las más sencillas que sean posibles, y que funcione tanto con Windows como con macOS y GNU Linux.

- Puedes instalar DeepSeek en cualquier ordenador para usarlo de forma local sin conectarte a ningún sitio. De hecho, no necesitas ni una conexión a Internet.

¿Qué es DeepSeek-R1?

DeepSeek-R1 es un modelo de IA open-source, gratis y diseñado para tareas que requieran mucho razonamiento (por ejemplo, resolución de problemas de programación, matemáticas avanzadas o procesos lógicos). La ventaja principal es que todo puede ejecutarse en tu computadora, sin mandar tus datos a servidores externos, lo que brinda privacidad y te ahorra los costos mensuales de otros proveedores populares.

¿Por qué DeepSeek-R1 es especial?

1º. Aprendizaje por Refuerzo (RL) vs. Entrenamiento Supervisado

DeepSeek-R1 se “entrena” resolviendo problemas por prueba y error, sin

depender tanto de datos de ejemplo etiquetados de forma tradicional.

Este proceso realza la capacidad de auto-verificación y reasoning de

largo alcance.

2º. Eficiencia de costos

- Si lo corres localmente, podés usar versiones “distilled” de entre 1.5B y 70B parámetros que funcionan incluso en GPU comunes (o con un poco de truco, en CPU potentes). Esto evita cuotas mensuales altas o costos por token.

- La versión completa alcanza hasta 671B parámetros, ideal para tareas súper complejas (Ahí si tenés que tener hardware de gama alta $$$).

3º. Flexibilidad open-source

Al ser abierto, no hay restricciones para integrarlo en tus proyectos.

Se puede tunear, combinar con otras bibliotecas o hasta crear tu propio

servicio web basado en DeepSeek-R1.

Para eso, vamos a recurrir a un programa que se llama Ollama, y que sirve para poder instalar distintos modelos de inteligencia artificial y lanzarlos en tu ordenador. Entre ellos está DeepSeek. Se instala como una aplicación normal, aunque su utilización es un poco diferente.

Su gran particularidad es que funciona desde la consola interna de tu sistema operativo, tanto la de Windows como la de macOS o GNU/Linux. Esto puede ser un poco confuso, aunque simplifica su utilización al máximo. De hecho, solo tienes que instalar la app y escribir un comando para empezar a hacerla funcionar.

La parte positiva de esto es que vas a poder usar DeepSeek incluso sin conexión a Internet, ya que estará funcionando internamente en tu ordenador. Y la parte negativa es que no puedes hacer búsquedas en Internet, al menos con este modelo R1 que vamos a instalar.

¿Qué es Ollama?

- Ollama (Open-source Library for AI Models and Applications)

Ollama es una herramienta de inteligencia artificial (IA) generativa diseñada para permitir a los usuarios generar contenido nuevo y realizar análisis avanzados de datos mediante modelos de lenguaje.

Ollama nos permitirá usar LLM (Large language model), esto es, modelos de lenguage entrenados para la IA, podrán ser de código abierto o de pago, podrán ser 100% offline o no, al gusto. Obviamente y dependiendo el LLM que usemos necesitaremos más o menos potencia, esto es, tener una GPU para que las respuestas sean inmediatas. Podremos usar la API de Ollama para hacerle preguntas de manera remota con otros sistemas, muy muy potente. Y os recomiendo Open WebUI como interfaz GUI para Ollama, así con nuestro navegador tendremos la interfaz que esperas para poder trabajar con tu IA cómodamente.

- Ofrece un buen soporte para modelos locales;

- Admite la calificación de mensajes a través de anotaciones RLHF para ajustar los modelos locales;

- Admite la marcación de conversaciones para clasificar y ubicar fácilmente chats específicos;

- Permite la descarga o eliminación de modelos directamente desde la interfaz;

- Permite especificar diferentes modelos para la conversación utilizando

@;

Lo dicho, necesitaremos una GPU para tener el mejor rendimiento posible,

dependerá del LLM que usemos y los GB que requiera cada modelo, de esta

manera las respuestas serán inmediatas. En cuanto al hardware

compatible es bastante extenso (NVIDIA, AMD, Apple M1…), os dejo aquí su listado.

Es parte de la creciente categoría de herramientas de IA que utilizan redes neuronales profundas para entender y producir lenguaje natural, lo que la hace útil en una variedad de aplicaciones, desde la generación automática de textos hasta la creación de scripts personalizados.

Características principales de Ollama:

Generación de contenido: Ollama puede generar texto coherente y relevante a partir de prompts o instrucciones dadas por el usuario, lo que la convierte en una herramienta valiosa para la automatización de tareas como la redacción de informes, la creación de documentación, y la elaboración de respuestas a incidentes de ciberseguridad.

Análisis de datos: Utilizando modelos avanzados de procesamiento de lenguaje natural (NLP), Ollama puede analizar grandes volúmenes de datos para extraer información útil, identificar patrones de comportamiento, y ofrecer insights que facilitan la toma de decisiones.

Personalización y ddaptabilidad: Ollama se puede adaptar a diferentes contextos y necesidades, permitiendo a los usuarios ajustar sus salidas según las especificaciones del proyecto o las demandas del entorno de trabajo.

Interfaz de usuario amigable: A pesar de su sofisticación técnica, Ollama está diseñada para ser accesible tanto para expertos en inteligencia artificial como para profesionales en campos no técnicos, facilitando su adopción en diferentes sectores.

Instalar DeepSeek en un PC

curl -fsSL https://ollama.com/install.sh | sh

Ahora, irás a la página donde tienes que elegir el sistema operativo para el que quieres bajarte el programa. Una vez lo hayas elegido, pulsa en el botón Download. Por defecto la web mostrará el sistema que estás usando, pero podrás descargar el ejecutable de cualquier otro.

Cuando lo descargues, lanza el programa de instalación. Instalar Ollama es muy sencillo, solo tienes que pulsar en el botón de siguiente en la pantalla de presentación, y luego pulsar en el botón Install en la pantalla de instalación.

Ahora viene la única parte un poco compleja. Una vez instalado, tienes que lanzar la aplicación de Ollama. Aparentemente no pasará nada, no se abrirá nada. En este punto, con Ollama funcionando tienes que abrir la terminal de tu sistema operativo, el símbolo de sistema en Windows. Allí, tienes que escribir el código para instalar o ejecutar DeepSeek. Es el siguiente:

ollama run <modelo>:<etiqueta>

- ollama pull deepseek-r1:8b: Esto solo descarga DeepSeek R1 en su versión 8B. Esta versión es algo más grande que las inferiores, pero es bastante más efectiva.

- ollama run deepseek-r1:8b: Esto instala y lanza DeepSeek R1 en la versión 8b o en la que elijas.

- Descarga de DeepSeek-R1 con Ollama

Elegir el modelo “distilled” que se ajuste a tu GPU (o CPU).-

1.5B parámetros (aprox. 1.1GB):

ollama run deepseek-r1:1.5b -

7B parámetros (aprox. 4.7GB):

ollama run deepseek-r1 -

70B parámetros (requiere +24GB de VRAM):

ollama run deepseek-r1:70b -

Versión completa 671B (para entusiastas con +300GB de VRAM):

ollama run deepseek-r1:671b

-

Cuando ejecutes deepseek vas a ver que empieza a descargar el modelo, y luego tendrás una terminal como la siguiente

El proceso de instalación es de varios gigas, unos 5, y lo mucho o poco que tarde dependerá de tu conexión a Internet. Una vez instalado, en el caso de haber usado el comando run ya podrás empezar a usarlo.

.Para utilizar Ollama:

- descargar modelos:

ollama pull llama2. Existen muchos modelos en https://ollama.com/library - ejecutar modelos:

ollama run lavay tendrás el modelo listo en una terminal - ver los modelos descargados:

ollama list - eliminar un modelo descargado:

ollama rm llama2 - también puedes arrancar Ollama desde la terminal sin necesidad de la aplicación de escritorio con

ollama serve - ejecutar una consulta desde el prompt

ollama run llama2 "why is ths sky blue?" - ejecutar una consulta desde el prompt pasándole un archivo como argumento para el contexto

ollama run llama2 "haz un resumen del siguiente archivo: $(cat README.md)" - ejecutar una consulta multimodal sobre una imagen en tu disco local

ollama run llava "what is in this image? /users/me/images/myimage.jpg" - saber más:

ollama --help

| Comando | Descripción |

ollama serve | Starts Ollama on your local system. |

ollama create <new_model> | Creates a new model from an existing one for customization or training. |

ollama show <model> | Displays details about a specific model, such as its configuration and release date. |

ollama run <model> | Runs the specified model, making it ready for interaction |

ollama pull <model> | Downloads the specified model to your system. |

ollama list | Lists all the downloaded models. |

ollama ps | Shows the currently running models. |

ollama stop <model> | Stops the specified running model. |

ollama rm <model> | Removes the specified model from your system. |

Cómo usar DeepSeek en tu PC

Cuando lances el programa, en la línea de comandos de tu ordenador podrás escribir el prompt que quieras lanzarle a DeepSeek, y tras unos segundos empezará a generarte la respuesta. Puedes usar DeepSeek en español si escribes en ese idioma, aunque su tendencia será usar el inglés. Si te responde en inglés, siempre puedes mencionar en el prompt que te responda en español.

El modelo DeepSeek R1 está especializado en el razonamiento. Por eso, cuando le escribas un prompt, antes de recibir la respuesta podrás ver su razonamiento

entre las etiquetas <think>. Esto es curioso para que puedas ver

la manera en la que la IA está procesando lo que le has preguntado.

Luego, te generará la respuesta.

Cuando quieras dejar de usar Ollama con DeepSeek, entonces tendrás que escribir el comando /bye, y te devolverá al terminal por defecto. Si escribes /? te mostrará otros comandos que puedes utilizar.

Uso de DeepSeek con una interfaz gráfica

Aunque puedes interactuar con DeepSeek directamente desde la terminal, muchos usuarios prefieren una interfaz gráfica para mayor comodidad. En este caso, puedes instalar ChatBoxAI, una aplicación gratuita que te permitirá aprovechar DeepSeek de forma visual.

- Descarga e instala ChatBoxAI desde su página oficial.

- Configura la aplicación para que utilice Ollama como proveedor de modelos:

En la configuración de ChatBoxAI, selecciona «Usar mi propia API» y elige el modelo de DeepSeek que descargaste previamente. Si todo está correctamente configurado, podrás realizar consultas y tareas directamente desde la interfaz gráfica.

Open WebUI

Open WebUI es una interfaz de IA de código abierto autohospedada, extensible, rica en funciones y fácil de usar, diseñada para funcionar completamente sin conexión. Es compatible con varios ejecutores de LLM, incluidos Ollama y la API compatible con OpenAI.

Ejecutar DeepSeek en una interfaz web

sudo apt install python3-venvpython3 -m venv ~/open-webui-venvsource ~/open-webui-venv/bin/activate

Ahora que tu entorno virtual está activo, puedes instalar Open WebUI usando pip.

pip install open-webui

open-webui serve

Configurar la API REST

Actualmente, el modelo está ejecutándose y Ollama crea un servidor HTTP local con una API REST que podemos usar, pero necesitamos configurar NGinx para habilitar el acceso mediante un proxy inverso.

$ sudo apt install nginx

Instalar NGinx es muy sencillo, solo ejecuta el comando anterior. Ahora, asegurémonos de permitir tráfico HTTP en el firewall:

$ sudo ufw allow 'Nginx HTTP'

Después, configuraremos el proxy inverso actualizando la configuración predeterminada de NGinx:

$ sudo vim /etc/nginx/sites-available/default

Comenta la configuración actual de /location que intenta servir archivos estáticos y copia-pega lo siguiente dentro del bloque server:

# Configuración original (comentar o eliminar para usar la nueva)

#location / {

# try_files $uri $uri/ =404;

#}

location / {

proxy_pass http://localhost:11434;

proxy_set_header Host localhost:11434;

# Manejar solicitudes preflight de CORS

if ($request_method = OPTIONS) {

add_header Access-Control-Allow-Origin *;

add_header Access-Control-Allow-Methods *;

add_header Access-Control-Allow-Headers "Content-Type, Authorization";

add_header Access-Control-Max-Age 3600;

return 200;

}

# Configurar encabezados CORS para otras respuestas

add_header Access-Control-Allow-Origin *;

add_header Access-Control-Allow-Methods *;

add_header Access-Control-Allow-Headers "Content-Type, Authorization";

proxy_set_header Origin "";

proxy_set_header Referer "";

}

Reinicia NGinx para aplicar los cambios:

$ sudo systemctl restart nginx

Por último, abre el puerto HTTP para tu IP (o cualquier servidor autorizado). Ve a la consola de AWS, haz clic en los detalles de la instancia (en mi caso DeepSeek AI), ve a la pestaña Seguridad, luego al enlace Grupos de seguridad, haz clic en Editar reglas de entrada, agrega una nueva regla, establece el puerto en 80 y selecciona My IP. Finalmente, guarda los cambios.

Abre tu navegador y ve a la dirección IP de tu instancia. Deberías ver un mensaje indicando que Ollama está ejecutándose.

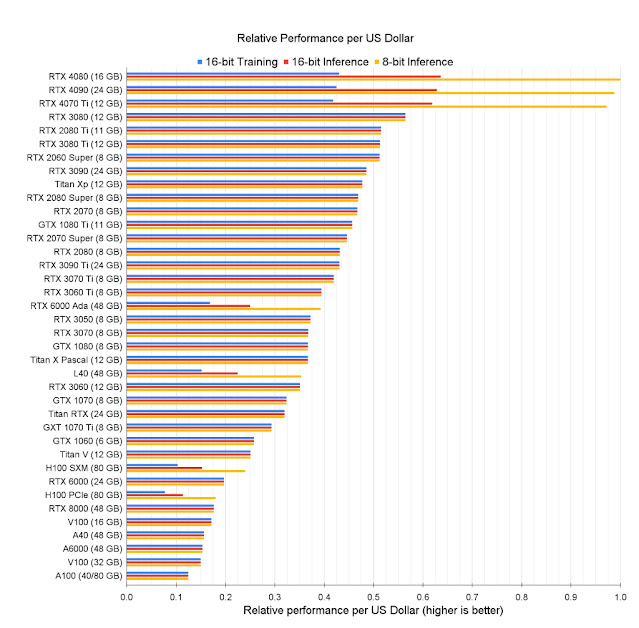

Requisitos de GPU para Ollama AI

1. VRAM (RAM de vídeo): La cantidad de VRAM necesaria depende del tamaño y la complejidad de los modelos que se utilicen. Aquí tienes una guía general basada en los LLM más comunes:

- Modelos Pequeños (hasta 7B parámetros): Requieren aproximadamente 8-12GB de VRAM.

- Modelos Medianos (8B a 14B parámetros): Requieren alrededor de 12-16GB de VRAM.

- Modelos grandes (más de 15B de parámetros): Pueden requerir 20GB o más, con algunos modelos muy grandes necesitando 48+GB de VRAM.

2. Núcleos CUDA: Un mayor número de núcleos CUDA ayuda al procesamiento paralelo, lo que acelera las tareas de entrenamiento e inferencia. Para obtener un rendimiento eficiente, se recomienda una GPU con al menos 3.000 núcleos CUDA, aunque un mayor número de núcleos es beneficioso para los modelos más grandes.

Integración de DeepSeek en proyectos

Si eres desarrollador, puedes integrar DeepSeek en tus proyectos mediante su API compatible con OpenAI. Aquí tienes un ejemplo sencillo utilizando Python:

import openai

client = openai.Client(base_url="http://localhost:11434/v1", api_key="ollama")

response = client.chat.completions.create(model="deepseek-r1", messages=[{"role": "user", "content": "Genera un código en Python para calcular Fibonacci"}]

Este script enviará una consulta al modelo local de DeepSeek y devolverá el resultado en tu terminal o aplicación.

El modelo de IA DeepSeek-R1 representa una excelente opción para aquellos que buscan una solución avanzada y económica. Con la facilidad de acceso que proporciona Ollama, la flexibilidad de sus modelos y la capacidad de integrarse en proyectos personalizados, DeepSeek abre nuevas posibilidades para desarrolladores, estudiantes y expertos en inteligencia artificial. Con su enfoque en privacidad y rendimiento, es una herramienta que merece ser explorada a fondo.

- Ollama es muy configurable mediante las variables de entorno (environment variable) permite especificar muchos parámetros.

Fuentes:

https://github.com/ollama/ollama/blob/main/docs/faq.md

https://www.xataka.com/basics/como-instalar-deepseek-para-usarlo-forma-local-tu-ordenador-windows-macos-gnu-linux

Entrada más reciente

Entrada más reciente

4 comentarios :

Tengo una duda, si quisiera instalar en una máquina offline, sin conexión de internet, puedo descargar todo y colocar luego toda esa instalación en la máquina offline?

Si

manuel el popeye

MegamanX prueba haciendo la instalación como ya se muestra arriba, en una pc con internet obvio.

El modelo se descarga por defecto en el directorio C:\Users\Usuario\.ollama <- Copiar toda la carpeta ".ollama" y llevar a la computadora sin internet, buscas el mismo directorio y pegas. En teoria deberia funcionar.

Publicar un comentario

Los comentarios pueden ser revisados en cualquier momento por los moderadores.

Serán publicados aquellos que cumplan las siguientes condiciones:

- Comentario acorde al contenido del post.

- Prohibido mensajes de tipo SPAM.

- Evite incluir links innecesarios en su comentario.

- Contenidos ofensivos, amenazas e insultos no serán permitidos.

Debe saber que los comentarios de los lectores no reflejan necesariamente la opinión del STAFF.