Tutoriales y Manuales

Entradas Mensuales

-

▼

2025

(Total:

2103

)

- ► septiembre (Total: 148 )

-

▼

julio

(Total:

95

)

-

Darcula PhaaS 3.0 genera automáticamente kits de p...

Darcula PhaaS 3.0 genera automáticamente kits de p...

-

Cuidado con los CAPTCHAs falsos que instalan malwa...

Cuidado con los CAPTCHAs falsos que instalan malwa...

-

La última idea de Elon Musk es un ojo biónico y lo...

La última idea de Elon Musk es un ojo biónico y lo...

-

"Es un psicópata": la reacción de un profesor al v...

"Es un psicópata": la reacción de un profesor al v...

-

Los 10 mejores bots para Discord

Los 10 mejores bots para Discord

-

Mensajes falsos suplantan al gobierno mexicano con...

Mensajes falsos suplantan al gobierno mexicano con...

-

Dropbox discontinua Passwords, su gestor de contra...

Dropbox discontinua Passwords, su gestor de contra...

-

Sound Blaster: la tarjeta de sonido que puso músic...

Sound Blaster: la tarjeta de sonido que puso músic...

-

La polémica tras la aparición en Vogue por primera...

La polémica tras la aparición en Vogue por primera...

-

Ataques homográficos usados en phishing saltan fil...

Ataques homográficos usados en phishing saltan fil...

-

Navegador Brave impide que Windows Recall realice ...

Navegador Brave impide que Windows Recall realice ...

-

ChatGPT presenta un nuevo modo de estudio que ayud...

ChatGPT presenta un nuevo modo de estudio que ayud...

-

En septiembre Netflix acabará para siempre con el ...

En septiembre Netflix acabará para siempre con el ...

-

Microsoft bloquea la cuenta de Hotmail de un desar...

Microsoft bloquea la cuenta de Hotmail de un desar...

-

Hackean Tea, una famosa app de citas y terminan ro...

Hackean Tea, una famosa app de citas y terminan ro...

-

Predator-OS: sistema operativo centrado en la segu...

Predator-OS: sistema operativo centrado en la segu...

-

GPT-5 de OpenAI destaca en tareas de programación

GPT-5 de OpenAI destaca en tareas de programación

-

LameHug: el primer malware con IA que hackea Windo...

LameHug: el primer malware con IA que hackea Windo...

-

Cómo crear vídeos con inteligencia artificial

Cómo crear vídeos con inteligencia artificial

-

Utilizan un radiador de coche para enfriar el Ryze...

Utilizan un radiador de coche para enfriar el Ryze...

-

Google presenta una nueva función que organiza los...

Google presenta una nueva función que organiza los...

-

Lego presenta el set Game Boy, una réplica de la p...

Lego presenta el set Game Boy, una réplica de la p...

-

Intel cancela su megafábrica en Europa

Intel cancela su megafábrica en Europa

-

Así funcionan las videollamadas dobladas a tiempo ...

Así funcionan las videollamadas dobladas a tiempo ...

-

Qwen3-Coder es una IA de Alibaba capaz de programa...

Qwen3-Coder es una IA de Alibaba capaz de programa...

-

Un ingeniero de Firefox advierte que las CPU Intel...

Un ingeniero de Firefox advierte que las CPU Intel...

-

'Entró en pánico y mintió': la increíble historia ...

'Entró en pánico y mintió': la increíble historia ...

-

Los resúmenes por IA de Google roban contenido y r...

Los resúmenes por IA de Google roban contenido y r...

-

Microsoft dice que chinos los que han usado la vul...

Microsoft dice que chinos los que han usado la vul...

-

Arrestan en Kiev al administrador del foro de cibe...

Arrestan en Kiev al administrador del foro de cibe...

-

Spotify publica canciones generadas por IA de dos ...

Spotify publica canciones generadas por IA de dos ...

-

Placas base Gigabyte vulnerables a malware vía UEF...

Placas base Gigabyte vulnerables a malware vía UEF...

-

LibreOffice acusa a Microsoft de usar formatos com...

LibreOffice acusa a Microsoft de usar formatos com...

-

Un bug en Windows 11 «permite» a los usuarios eyec...

Un bug en Windows 11 «permite» a los usuarios eyec...

-

Walker S2, el primer robot humanoide del mundo que...

Walker S2, el primer robot humanoide del mundo que...

-

Google desarrolla un sistema que aprovecha los ace...

Google desarrolla un sistema que aprovecha los ace...

-

Así son los cables submarinos de Google y Meta par...

Así son los cables submarinos de Google y Meta par...

-

OpenAI presenta el agente ChatGPT, que puede contr...

OpenAI presenta el agente ChatGPT, que puede contr...

-

Vecinos organizados manipulan a Google Maps para q...

Vecinos organizados manipulan a Google Maps para q...

-

Operación mundial Europol contra la red pro Rusa d...

Operación mundial Europol contra la red pro Rusa d...

-

La Unión Europea lanza un prototipo de sistema de ...

La Unión Europea lanza un prototipo de sistema de ...

-

Un youtuber podría ir a la cárcel por reseñar cons...

Un youtuber podría ir a la cárcel por reseñar cons...

-

El juego ya no es tuyo, Ubisoft exige que destruya...

El juego ya no es tuyo, Ubisoft exige que destruya...

-

Las reservas de los AMD Threadripper 9000 empiezan...

Las reservas de los AMD Threadripper 9000 empiezan...

-

¿Quién es Ruoming Pang? El ingeniero que ha fichad...

¿Quién es Ruoming Pang? El ingeniero que ha fichad...

-

WeTransfer habilita el uso de IA para moderar cont...

WeTransfer habilita el uso de IA para moderar cont...

-

xAI ha tenido que disculparse por Grok

xAI ha tenido que disculparse por Grok

-

Europa lo dice claro: un juego comprado pertenece ...

Europa lo dice claro: un juego comprado pertenece ...

-

¿Qué pruebas se usan para medir lo "inteligente" q...

¿Qué pruebas se usan para medir lo "inteligente" q...

-

El MP3: la historia del formato que cambió la músi...

El MP3: la historia del formato que cambió la músi...

-

Un SSD que puede autodestruir sus datos pulsando u...

Un SSD que puede autodestruir sus datos pulsando u...

-

Cinta holográfica, el sucesor de la cinta magnétic...

Cinta holográfica, el sucesor de la cinta magnétic...

-

Grok 4 consulta a Elon Musk antes de responder sob...

Grok 4 consulta a Elon Musk antes de responder sob...

-

Interior se blinda con un programa de EEUU ante la...

Interior se blinda con un programa de EEUU ante la...

-

El FBI cierra una conocida web de piratería de Nin...

El FBI cierra una conocida web de piratería de Nin...

-

Se filtran los sueldos de Google en 2025: hasta 34...

Se filtran los sueldos de Google en 2025: hasta 34...

-

Broadcom finalmente no construirá una planta de se...

Broadcom finalmente no construirá una planta de se...

-

DNS4EU: los servidores DNS públicos Europeos con f...

DNS4EU: los servidores DNS públicos Europeos con f...

-

Kimi K2, una IA de código abierto que supera a Gem...

Kimi K2, una IA de código abierto que supera a Gem...

-

Microsoft Defender: La inteligencia artificial apr...

Microsoft Defender: La inteligencia artificial apr...

-

Los infostealers más activos en Latinoamérica

Los infostealers más activos en Latinoamérica

-

El navegador web de OpenAI

El navegador web de OpenAI

-

Cómo las armas de fuego impresas en 3D se están pr...

Cómo las armas de fuego impresas en 3D se están pr...

-

Análisis Técnico Comparativo: La Guerra de las Arq...

Análisis Técnico Comparativo: La Guerra de las Arq...

-

Samsung presenta los móviles plegables Galaxy Z Fo...

Samsung presenta los móviles plegables Galaxy Z Fo...

-

Interceptan el primer 'narcosubmarino' sin tripula...

Interceptan el primer 'narcosubmarino' sin tripula...

-

Usando IA roba la identidad del Secretario de Esta...

Usando IA roba la identidad del Secretario de Esta...

-

Bitchat, la app del creador de Twitter que se pued...

Bitchat, la app del creador de Twitter que se pued...

-

OnePlus presenta los teéfonos Nord 5 y Nord CE5

OnePlus presenta los teéfonos Nord 5 y Nord CE5

-

El grupo ransomware Hunters International cierra y...

El grupo ransomware Hunters International cierra y...

-

Lossless Scaling Frame Generation ya funciona en L...

Lossless Scaling Frame Generation ya funciona en L...

-

Parrot 6.4: la distro hacking ético basada en Debi...

Parrot 6.4: la distro hacking ético basada en Debi...

-

Descubren una «vulnerabilidad» mediante acceso fís...

Descubren una «vulnerabilidad» mediante acceso fís...

-

Dispositivo con doble láser fulmina los mosquitos ...

Dispositivo con doble láser fulmina los mosquitos ...

-

Un estudio descubre que la IA no comprende lo que ...

Un estudio descubre que la IA no comprende lo que ...

-

El nuevo modo de ChatGPT «Study Together, te ayuda...

El nuevo modo de ChatGPT «Study Together, te ayuda...

-

Bomb C4: Atacando el cifrado de cookies AppBound d...

Bomb C4: Atacando el cifrado de cookies AppBound d...

-

Dos vulnerabilidades críticas en Sudo comprometen ...

Dos vulnerabilidades críticas en Sudo comprometen ...

-

Los mejores trucos para usar GPT-4 como un experto

Los mejores trucos para usar GPT-4 como un experto

-

Google lanza globalmente Veo 3, su modelo de IA pa...

Google lanza globalmente Veo 3, su modelo de IA pa...

-

Se hacen con el control de una presa durante 4 hor...

Se hacen con el control de una presa durante 4 hor...

-

Google se enfrenta a una multa millonaria por rast...

Google se enfrenta a una multa millonaria por rast...

-

Catlog, un collar inteligente con IA que te avisa ...

Catlog, un collar inteligente con IA que te avisa ...

-

En los almacenes de Amazon pronto habrá más robots...

En los almacenes de Amazon pronto habrá más robots...

-

Microsoft despide a 9.000 empleados

Microsoft despide a 9.000 empleados

-

Microsoft dice que Windows 11 es 2 veces más rápid...

Microsoft dice que Windows 11 es 2 veces más rápid...

-

Vendía iPhones en Wallapop a menos de la mitad de ...

Vendía iPhones en Wallapop a menos de la mitad de ...

-

"Buscar mi iPhone" no recuperó el teléfono, pero d...

"Buscar mi iPhone" no recuperó el teléfono, pero d...

-

Cloudflare bloqueará por defecto los rastreadores ...

Cloudflare bloqueará por defecto los rastreadores ...

-

La Policía Nacional España detiene dos jóvenes de ...

La Policía Nacional España detiene dos jóvenes de ...

-

China apuesta por el fútbol de robots humanoides

China apuesta por el fútbol de robots humanoides

-

Windows pierde 400 millones de usuarios

Windows pierde 400 millones de usuarios

-

Otra vulnerabilidad Zero-Day en Google Chrome

Otra vulnerabilidad Zero-Day en Google Chrome

-

Microsoft afirma que su nuevo sistema de IA diagno...

Microsoft afirma que su nuevo sistema de IA diagno...

-

Desmantelada en España una red de fraude en cripto...

Desmantelada en España una red de fraude en cripto...

-

-

►

2024

(Total:

1110

)

- ► septiembre (Total: 50 )

-

►

2023

(Total:

710

)

- ► septiembre (Total: 65 )

-

►

2022

(Total:

967

)

- ► septiembre (Total: 72 )

-

►

2021

(Total:

730

)

- ► septiembre (Total: 56 )

-

►

2020

(Total:

212

)

- ► septiembre (Total: 21 )

-

►

2019

(Total:

102

)

- ► septiembre (Total: 14 )

-

►

2017

(Total:

231

)

- ► septiembre (Total: 16 )

-

►

2016

(Total:

266

)

- ► septiembre (Total: 38 )

-

►

2015

(Total:

445

)

- ► septiembre (Total: 47 )

-

►

2014

(Total:

185

)

- ► septiembre (Total: 18 )

-

►

2013

(Total:

100

)

- ► septiembre (Total: 3 )

-

►

2011

(Total:

7

)

- ► septiembre (Total: 1 )

Blogroll

Etiquetas

Entradas populares

Entradas populares

-

El experto en ciberseguridad Ben van der Burg recomienda abandonar WhatsApp y Gmail por alternativas europeas, argumentando que aunque son...

-

ClothOff es una app que utiliza inteligencia artificial generativa para desnudar a cualquier persona a partir de fotografías con ropa que...

-

Un proyecto permite actualizar Windows 7 hasta enero de 2026 , añadiendo soporte para SSDs NVMe y USB 3.x , mejorando su seguridad y compati...

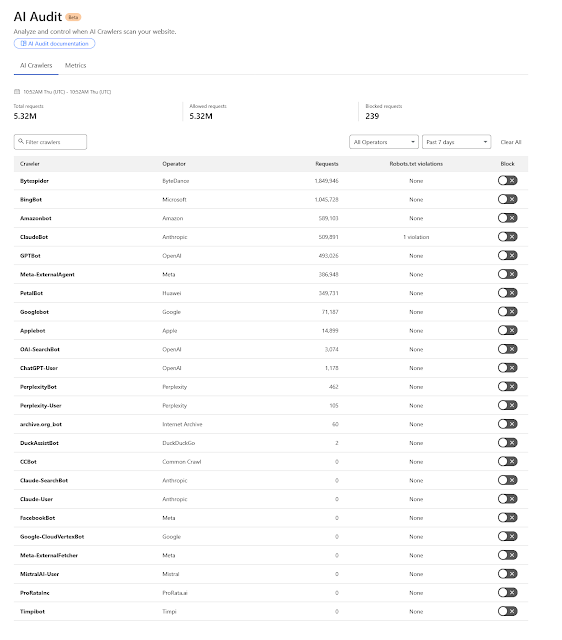

Cloudflare bloqueará por defecto los rastreadores de contenido web IA

Cloudflare bloqueará por defecto los rastreadores de contenido web IA

El pasado mes de junio trajo dos buenas noticias para las empresas que desarrollan herramientas de inteligencia artificial generativa. Dos sentencias emitidas en California, que afectan a Anthropic en un caso y a Meta en otro, encuadran el haber alimentado con libros protegidos por derechos de autor a sus modelos de inteligencia artificial dentro del fair use o uso justo que permite la legislación estadounidense. Es decir, no tenían que compensar económicamente a nadie por hacerlo. Sin embargo, no todo rema en esa dirección y ahora ha sido Cloudflare, uno de los principales proveedores de la infraestructura de Internet, quien ha tomado una medida que pondrá las cosas más difíciles a los chatbots que generan sus respuestas a partir de la información que encuentran en la Red.

- Uno de los principales proveedores de la infraestructura de Internet lanza el programa Pay Per Crawl o Paga por rastrear que permitirá a las webs fijar un precio para que los rastreadores de IA accedan a su contenido

Si esto es importante, es porque Cloudflare es una de las patas sobre las que se asienta Internet proporcionando servicios como CDN (que distribuye el contenido por servidores en todo el mundo para que las webs carguen más rápido desde cualquier lugar), DNS (traduce los nombres de los dominios en direcciones IP que entienden los ordenadores) y protección contra ataques, entre otros. Buena parte de Internet pasa por sus servidores y servicios.

Paga por rastrear

Así, el programa Pay Per Crawl permitirá a los editores fijar un precio para que los rastreadores de IA accedan a su contenido. Las empresas de IA podrán consultar las tarifas y decidir si se registran para pagar la cuota o si desisten. Por ahora, esto solo está disponible en fase beta para ‘un grupo de algunos de los principales editores y creadores de contenido’, entre los que se encuentran The Associated Press, The Atlantic, Fortune, Stack Overflow, Quora y otros, pero Cloudflare asegura que garantizará que ‘las empresas de IA puedan utilizar contenido de calidad de la forma correcta: con permiso y compensación’. Los administradores de sitios web que estén interesados pueden apuntarse a la beta aquí.

Cloudfare quiere poner freno a la voracidad de la IA

Cloudflare lleva

tiempo ayudando a los propietarios de webs a defenderse de los

rastreadores de IA. Una de las preocupaciones del sector es que, desde

que ha explotado la IA y Google la ha añadido a su Buscador, han visto cómo se reducen las visitas a sus páginas, dado que el usuario ya encuentra lo que busca en un chatbot como ChatGPT o en las Vistas creadas con IA

que resumen la información que los usuarios buscan en Google. El acceso

a la información con la que alimentan las respuestas de los chatbots ha sido, hasta ahora, una barra libre para las empresas de IA, pero Cloudflare quiere que eso cambie.

‘La gente confía más en la IA en los últimos seis meses, lo que significa que no leen el contenido original’, afirmó el CEO de Cloudflare, Matthew Prince, durante el evento Axios Live la semana pasada.

Cómo solucionar este rastreo indiscriminado y sin contraprestación? La primera propuesta fue actualizar el archivo robots.txt para indicarle a los bots que no pueden extraer el contenido de una web. Este archivo e uno de los recursos más usados para administrar la actividad de los bots, pero tiene un pequeño gran problema: su cumplimiento es voluntario. Las empresas de IA pueden seguir las instrucciones, o pueden ignorarlas y extraer el contenido.

La compañía empezó a permitir que los sitios web bloquearan a los rastreadores de IA en 2023, aunque esto solo se aplicaba a aquellos que respetaban el archivo robots.txt del sitio. Este es un archivo de texto alojado en el servidor que los sitios web usan para indicar a los bots y rastreadores qué partes de su contenido pueden o no explorar e indexar. La empresa identifica a los rastreadores que debe bloquear comparándolos con su lista de bots de IA conocidos.

El año pasado, Cloudflare permitió que los sitios bloquearan a ‘todos’ los bots de IA, independientemente de si respetaban o no el robots.txt, y ahora esta configuración está activada por defecto para los nuevos clientes de Cloudflare.

Además, puede pasar que toquemos lo que no debemos y que nuestra web desaparezca de Google. Toda web que quiera estar en Google debe permitir que GoogleBot, su araña, la rastree. El problema es que Google usa el user agent "GoogleBot" tanto para el SEO como para la IA. Si alguien bloquea "GoogleBot" en su web, estará desapareciendo de facto de Google. La clave sería bloquear "Google-Extended", que es el crawler de IA, pero esta diferenciación habría que hacerla bot a bot, una a una. Es una tarea laboriosa, como se puede deducir.

Además, Cloudflare lanzó en marzo una función que desvía a los bots rastreadores hacia un ‘Laberinto de IA’ para desincentivar extraer contenido sin permiso. Este sistema disuade el scraping

(recopilar de forma automática datos de los sitios web) redirigiendo a

los bots rastreadores a enlaces falsos o que no contienen información

útil, haciéndoles gastar tiempo y recursos en procesos inútiles.

Cloudflare señala que está colaborando con empresas de IA para ayudar a verificar sus rastreadores y permitirles ‘declarar claramente su propósito’, como si usan el contenido para entrenamiento, inferencia o búsqueda. Los propietarios de los sitios web podrán revisar esta información y decidir a qué rastreadores permiten el acceso.

‘El contenido

original es lo que hace de Internet uno de los mayores inventos del

último siglo, y tenemos que unirnos para protegerlo’, señala Prince

en el comunicado de prensa. ‘Los rastreadores de IA han estado

extrayendo contenido sin límites. Nuestro objetivo es devolver el poder a

los creadores, sin dejar de ayudar a las empresas de IA a innovar’,

añade.

CloudFlare Pay per Crawl

https://www.elladodelmal.com/2025/07/cloudflare-pay-per-crawl-un-servicio.html

Entrada más reciente

Entrada más reciente

0 comentarios :

Publicar un comentario

Los comentarios pueden ser revisados en cualquier momento por los moderadores.

Serán publicados aquellos que cumplan las siguientes condiciones:

- Comentario acorde al contenido del post.

- Prohibido mensajes de tipo SPAM.

- Evite incluir links innecesarios en su comentario.

- Contenidos ofensivos, amenazas e insultos no serán permitidos.

Debe saber que los comentarios de los lectores no reflejan necesariamente la opinión del STAFF.