Tutoriales y Manuales

Entradas Mensuales

-

▼

2025

(Total:

2103

)

- ► septiembre (Total: 148 )

-

▼

marzo

(Total:

157

)

-

Telegram supera los mil millones de usuarios

Telegram supera los mil millones de usuarios

-

Cómo un exploit de la NSA se convirtió en el orige...

Cómo un exploit de la NSA se convirtió en el orige...

-

¿Qué es JPEG XL?

¿Qué es JPEG XL?

-

¿Qué son los shaders y por qué debes esperar antes...

¿Qué son los shaders y por qué debes esperar antes...

-

Neurodatos: qué son y por qué son el futuro

Neurodatos: qué son y por qué son el futuro

-

¿Qué es un ASIC?

¿Qué es un ASIC?

-

Calibre 8.1 mejora su compatibilidad con macOS e i...

Calibre 8.1 mejora su compatibilidad con macOS e i...

-

Alcasec vendió datos sensibles de 130.000 policías...

Alcasec vendió datos sensibles de 130.000 policías...

-

Hackean un proveedor de SMS y lo utilizan para rob...

Hackean un proveedor de SMS y lo utilizan para rob...

-

Filtración masiva de 6 millones registros de Oracl...

Filtración masiva de 6 millones registros de Oracl...

-

Vulnerabilidades críticas en Veeam Backup e IBM AIX

Vulnerabilidades críticas en Veeam Backup e IBM AIX

-

IngressNightmare: vulnerabilidades críticas del co...

IngressNightmare: vulnerabilidades críticas del co...

-

El 87% de lo usuarios hace copias de seguridad, pe...

El 87% de lo usuarios hace copias de seguridad, pe...

-

Vulnerabilidad crítica en Next.js

Vulnerabilidad crítica en Next.js

-

Hacker antigobierno hackea casi una decena de siti...

Hacker antigobierno hackea casi una decena de siti...

-

Google confirma que el desarrollo de Android pasar...

Google confirma que el desarrollo de Android pasar...

-

Ubuntu 25.04 beta ya disponible, con GNOME 48 y Li...

Ubuntu 25.04 beta ya disponible, con GNOME 48 y Li...

-

Anthropic asegura haber descubierto cómo ‘piensan’...

Anthropic asegura haber descubierto cómo ‘piensan’...

-

ChatGPT, Gemini y Claude no pueden con un test que...

ChatGPT, Gemini y Claude no pueden con un test que...

-

Amazon presenta ‘Intereses’ una IA que caza oferta...

Amazon presenta ‘Intereses’ una IA que caza oferta...

-

Microsoft rediseña el inicio de sesión para que te...

Microsoft rediseña el inicio de sesión para que te...

-

¿Qué significa «in the coming days»? la tendencia ...

¿Qué significa «in the coming days»? la tendencia ...

-

Por culpa de Trump, empresas y gobiernos europeos ...

Por culpa de Trump, empresas y gobiernos europeos ...

-

Signal es seguro… hasta que invitas a un periodist...

Signal es seguro… hasta que invitas a un periodist...

-

ChatGPT puede crear imágenes realistas gracias al ...

ChatGPT puede crear imágenes realistas gracias al ...

-

Evolución del menú de inicio de Windows en casi 3...

Evolución del menú de inicio de Windows en casi 3...

-

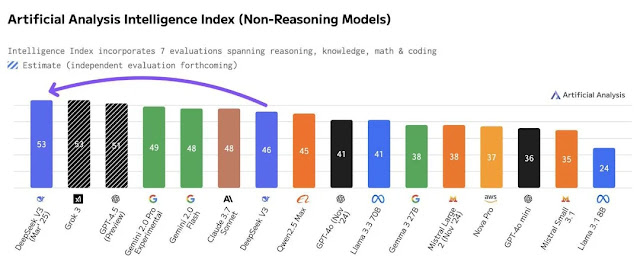

Gemini 2.5 Pro es el “modelo de IA más inteligente...

Gemini 2.5 Pro es el “modelo de IA más inteligente...

-

DeepSeek presenta un nuevo modelo de IA optimizado...

DeepSeek presenta un nuevo modelo de IA optimizado...

-

Samsung y Google tienen casi listas sus gafas con ...

Samsung y Google tienen casi listas sus gafas con ...

-

⚡️ NVMe sobre TCP/IP

⚡️ NVMe sobre TCP/IP

-

🇰🇵 Corea del Norte se prepara para la ciberguerr...

🇰🇵 Corea del Norte se prepara para la ciberguerr...

-

🇨🇳 Los creadores de Deepseek tienen prohibido ir...

🇨🇳 Los creadores de Deepseek tienen prohibido ir...

-

Microsoft usará agentes autónomos de IA para comba...

Microsoft usará agentes autónomos de IA para comba...

-

EU OS: La nueva alternativa Linux comunitaria para...

EU OS: La nueva alternativa Linux comunitaria para...

-

China presenta un arma capaz de cortar cualquier c...

China presenta un arma capaz de cortar cualquier c...

-

Historia de Apple

Historia de Apple

-

Microsoft le dice a los usuarios de Windows 10 que...

Microsoft le dice a los usuarios de Windows 10 que...

-

ReactOS el «Windows de código abierto», se actualiza

ReactOS el «Windows de código abierto», se actualiza

-

Denuncia a OpenAI después de que ChatGPT le acusar...

Denuncia a OpenAI después de que ChatGPT le acusar...

-

💾 Seagate presenta un disco duro mecánico con int...

💾 Seagate presenta un disco duro mecánico con int...

-

🤖 Claude ya permite buscar en internet para obten...

🤖 Claude ya permite buscar en internet para obten...

-

Meta AI llega finalmente a Europa, integrando su c...

Meta AI llega finalmente a Europa, integrando su c...

-

Francia rechaza la creación de puertas traseras en...

Francia rechaza la creación de puertas traseras en...

-

🤖Cómo saber si una imagen o vídeo ha sido generad...

🤖Cómo saber si una imagen o vídeo ha sido generad...

-

OpenAI presenta dos nuevos modelos de audio para C...

OpenAI presenta dos nuevos modelos de audio para C...

-

El cofundador de Instagram revela a lo que se dedi...

El cofundador de Instagram revela a lo que se dedi...

-

Vigilancia masiva con sistemas de posicionamiento ...

Vigilancia masiva con sistemas de posicionamiento ...

-

Las 20 mejores herramientas de Kali Linux para 2025

Las 20 mejores herramientas de Kali Linux para 2025

-

Cómo instalar Stable Diffusion (para generar imáge...

Cómo instalar Stable Diffusion (para generar imáge...

-

La primera versión de Kali Linux de 2025

La primera versión de Kali Linux de 2025

-

Marruecos: más de 31,000 tarjetas bancarias divulg...

Marruecos: más de 31,000 tarjetas bancarias divulg...

-

Modo Dios en Android Auto

Modo Dios en Android Auto

-

Google anuncia el Pixel 9a, con funciones de IA, e...

Google anuncia el Pixel 9a, con funciones de IA, e...

-

Europa fuerza a Apple a abrir su ecosistema y acus...

Europa fuerza a Apple a abrir su ecosistema y acus...

-

La App Contraseñas de Apple fue durante tres meses...

La App Contraseñas de Apple fue durante tres meses...

-

Adiós, Photoshop: Gemini ahora te permite editar i...

Adiós, Photoshop: Gemini ahora te permite editar i...

-

Microsoft alerta de un troyano que desde Chrome ro...

Microsoft alerta de un troyano que desde Chrome ro...

-

Llevan meses explotando una vulnerabilidad de Chat...

Llevan meses explotando una vulnerabilidad de Chat...

-

Teclado que no utiliza letras, sino palabras compl...

Teclado que no utiliza letras, sino palabras compl...

-

La GPU se une a los discos duros basados en PCIe: ...

La GPU se une a los discos duros basados en PCIe: ...

-

Un ciberataque compromete 330 GB de datos confiden...

Un ciberataque compromete 330 GB de datos confiden...

-

NVIDIA presenta los modelos de razonamiento de IA ...

NVIDIA presenta los modelos de razonamiento de IA ...

-

La mítica marca Española de calzado J´Hayber vícti...

La mítica marca Española de calzado J´Hayber vícti...

-

La RAE confirma haber sufrido un ataque de ransomware

La RAE confirma haber sufrido un ataque de ransomware

-

NVIDIA BlackWell RTX PRO 6000 con 96 GB de VRAM y ...

NVIDIA BlackWell RTX PRO 6000 con 96 GB de VRAM y ...

-

China construye una base submarina a 2 km de profu...

China construye una base submarina a 2 km de profu...

-

Los creadores de Stable Diffusion presentan una IA...

Los creadores de Stable Diffusion presentan una IA...

-

Utilizan una vulnerabilidad crítica en dispositivo...

Utilizan una vulnerabilidad crítica en dispositivo...

-

Vulnerabilidad de suplantación en el Explorador de...

Vulnerabilidad de suplantación en el Explorador de...

-

NVIDIA Isaac GR00T N1, la primera IA de código abi...

NVIDIA Isaac GR00T N1, la primera IA de código abi...

-

Campaña de Phishing: "Alerta de seguridad" FALSA e...

Campaña de Phishing: "Alerta de seguridad" FALSA e...

-

🔈Amazon Echo: o cedes tus datos y privacidad a la...

🔈Amazon Echo: o cedes tus datos y privacidad a la...

-

Descifrador del ransomware Akira mediante GPU

Descifrador del ransomware Akira mediante GPU

-

Google compra Wiz por 32.000 millones de dólares, ...

Google compra Wiz por 32.000 millones de dólares, ...

-

Una nueva técnica envía sonido a una persona espec...

Una nueva técnica envía sonido a una persona espec...

-

GIMP 3: ya puedes descargar la nueva versión del e...

GIMP 3: ya puedes descargar la nueva versión del e...

-

“Hackearon mi teléfono y mi cuenta de correo elect...

“Hackearon mi teléfono y mi cuenta de correo elect...

-

Generar imágenes mediante IA con Stable Diffusion

Generar imágenes mediante IA con Stable Diffusion

-

Steve Wozniak alerta del uso de la IA como «herram...

Steve Wozniak alerta del uso de la IA como «herram...

-

La IA de código abierto iguala a los mejores LLM p...

La IA de código abierto iguala a los mejores LLM p...

-

Grupo Lazarus de Corea del Norte hizo el mayor rob...

Grupo Lazarus de Corea del Norte hizo el mayor rob...

-

El FBI y CISA alertan ante el aumento de los ataqu...

El FBI y CISA alertan ante el aumento de los ataqu...

-

Android 16 incluirá Battery Health

Android 16 incluirá Battery Health

-

SteamOS para PC, la alternativa a Windows

SteamOS para PC, la alternativa a Windows

-

Venden acceso total a red de gasolineras de México...

Venden acceso total a red de gasolineras de México...

-

La banda de ransomware Akira utiliza webcams para ...

La banda de ransomware Akira utiliza webcams para ...

-

ASUS anuncia monitores con purificador de aire inc...

ASUS anuncia monitores con purificador de aire inc...

-

Facebook, Instagram y Threads empiezan a probar la...

Facebook, Instagram y Threads empiezan a probar la...

-

Texas Instruments crea el microcontrolador más peq...

Texas Instruments crea el microcontrolador más peq...

-

Algunas impresoras están imprimiendo texto aleator...

Algunas impresoras están imprimiendo texto aleator...

-

Deep Research, la herramienta de Gemini que convie...

Deep Research, la herramienta de Gemini que convie...

-

La nueva versión de Visual Studio Code te permite ...

La nueva versión de Visual Studio Code te permite ...

-

Las descargas de LibreOffice se disparan con el re...

Las descargas de LibreOffice se disparan con el re...

-

China anuncia una nueva tecnología que permite ver...

China anuncia una nueva tecnología que permite ver...

-

Google anuncia Gemma 3: su nueva IA ligera para di...

Google anuncia Gemma 3: su nueva IA ligera para di...

-

Gemini puede usar tu historial de Google para dart...

Gemini puede usar tu historial de Google para dart...

-

MySQL Replication (Master-Slave)

MySQL Replication (Master-Slave)

-

Advierten sobre Grandoreiro, troyano brasileño que...

Advierten sobre Grandoreiro, troyano brasileño que...

-

Retan a ChatGPT y DeepSeek a jugar al ajedrez y lo...

Retan a ChatGPT y DeepSeek a jugar al ajedrez y lo...

-

Una actualización de HP deja inservibles a sus imp...

Una actualización de HP deja inservibles a sus imp...

-

-

►

2024

(Total:

1110

)

- ► septiembre (Total: 50 )

-

►

2023

(Total:

710

)

- ► septiembre (Total: 65 )

-

►

2022

(Total:

967

)

- ► septiembre (Total: 72 )

-

►

2021

(Total:

730

)

- ► septiembre (Total: 56 )

-

►

2020

(Total:

212

)

- ► septiembre (Total: 21 )

-

►

2019

(Total:

102

)

- ► septiembre (Total: 14 )

-

►

2017

(Total:

231

)

- ► septiembre (Total: 16 )

-

►

2016

(Total:

266

)

- ► septiembre (Total: 38 )

-

►

2015

(Total:

445

)

- ► septiembre (Total: 47 )

-

►

2014

(Total:

185

)

- ► septiembre (Total: 18 )

-

►

2013

(Total:

100

)

- ► septiembre (Total: 3 )

-

►

2011

(Total:

7

)

- ► septiembre (Total: 1 )

Blogroll

Etiquetas

Entradas populares

Entradas populares

-

IKEA lanza el enchufe inteligente INSPELNING , por menos de 10 euros , que reduce la factura de luz al medir el consumo eléctrico y es com...

-

El Kode Dot es un dispositivo portátil que asusta a expertos en ciberseguridad por su capacidad para controlar casi cualquier sistema , f...

-

Un proyecto permite actualizar Windows 7 hasta enero de 2026 , añadiendo soporte para SSDs NVMe y USB 3.x , mejorando su seguridad y compati...

DeepSeek presenta un nuevo modelo de IA optimizado: DeepSeek V3-0324 (700GB)

DeepSeek presenta un nuevo modelo de IA optimizado: DeepSeek V3-0324 (700GB)

DeepSeek, la empresa china que puso de cabeza a OpenAI y otras empresas tecnológicas, ha lanzado la última versión de su modelo estrella: DeepSeek V3-0324. Esta inesperada actualización introduce mejoras en rendimiento y accesibilidad, posicionándolo como uno de los modelos de IA más avanzados para el usuario final. Una de sus características más llamativas es su capacidad para ejecutarse en un Mac Studio con chip M3 a una velocidad sorprendente.

- DeepSeek V3-0324 es un nuevo modelo de IA optimizado para ejecutarse en ordenadores de gama alta, como el Mac Studio con chip M3 Ultra.

A diferencia de DeepSeek V3, el nuevo modelo, con 685 mil millones de parámetros, mejora significativamente la velocidad y eficiencia del procesamiento. Esto lo convierte en una opción más viable para ejecutarse en ordenadores de consumo de gama alta.

Según las primeras pruebas, DeepSeek V3-0324 puede ofrecer un rendimiento superior a 20 tokens por segundo en un Mac Studio M3 Ultra con 512 GB de memoria unificada. Esta velocidad se logra mediante MLX, una biblioteca de código abierto que optimiza la ejecución de modelos de gran tamaño.

DeepSeek V3-0324 utiliza cuantificación de 4 bits mediante el complemento mlx-community/DeepSeek-V3-0324-4bit,

lo que reduce el tamaño del modelo en disco de 641 GB a unos 352 GB más

manejables. Este nivel de optimización permite ejecutar el modelo en

hardware que antes se consideraba insuficiente para tareas de IA a gran

escala.

Otro cambio notable es el nuevo esquema de licencia. DeepSeek ha publicado la versión V3-0324 bajo la licencia MIT, alejándose de la licencia propietaria de su predecesor. Este cambio permitirá a los desarrolladores integrarlo libremente en proyectos comerciales y de código abierto, ampliando sus posibles aplicaciones. Sin embargo, la empresa aún no ha proporcionado documentación completa (el archivo README está vacío), aunque la comunidad ya ha comenzado a experimentar con el modelo.

DeepSeek V3-0324, su modelo de IA más potente y "accesible"

Uno de los aspectos distintivos del lanzamiento de DeepSeek fue su entrenamiento con bajo poder de cómputo. Esto es posible gracias a la arquitectura MoE (Mixture of Experts), que activa solo las partes del modelo necesarias para una tarea específica. A diferencia de modelos más monolíticos como GPT-4.5, DeepSeek divide el modelo en componentes especializados, optimizando así el uso de recursos.

Un Mac Studio con 512GB RAM

El aprovechamiento de hardware y técnicas optimizadas se ha ampliado en esta versión, eliminando la necesidad de depender exclusivamente de soluciones en la nube. No obstante, DeepSeek V3-0324 sigue requiriendo un ordenador de gama alta. Un Mac Studio M3 Ultra con 512 GB de memoria cuesta unos 15.000 euros, lo que supone una inversión considerable para quienes deseen ejecutar el modelo de forma local.

Aquellos con el hardware adecuado pueden acceder al modelo a través del complemento llm-mlx, ejecutando los siguientes comandos:

llm mlx download-model mlx-community/DeepSeek-V3-0324-4bit

llm chat -m mlx-community/DeepSeek-V3-0324-4bit

Fuentes:

https://hipertextual.com/2025/03/deepseek-nuevo-modelo-ia-se-ejecuta-en-mac-studio

.png)

Entrada más reciente

Entrada más reciente

0 comentarios :

Publicar un comentario

Los comentarios pueden ser revisados en cualquier momento por los moderadores.

Serán publicados aquellos que cumplan las siguientes condiciones:

- Comentario acorde al contenido del post.

- Prohibido mensajes de tipo SPAM.

- Evite incluir links innecesarios en su comentario.

- Contenidos ofensivos, amenazas e insultos no serán permitidos.

Debe saber que los comentarios de los lectores no reflejan necesariamente la opinión del STAFF.